Spletna revija za znanstvenike, strokovnjake

in nevroznanstvene navdušence

Naslovnica Članki Intervjuji Mnenja Zdravje Korenine eSinapsa Številke ![]()

Umetno inteligentna nevroznanost: srečanje nevronskih mrež in možganske fiziologije

članki

eSinapsa, 2011-1

Zvezdan Pirtošek

Eksoskeleti – inteligentne bionske naprave

Marko Munih

O aktualnih dilemah draženja globokih možganskih struktur pri obsesivno - kompulzivni motnji

Nadja Jarc

Sledite svojo srečo ... z iPhone

Urban Kordeš

eSinapsa, 2011-2

Renata Salecl

Gašper Tkačik

Astrociti – spregledane zvezde nevrobiologije

Marko Kreft, Robert Zorec

Sašo Dolenc

Meditacija - malo truda, veliko koristi

Luka Dimic

eSinapsa, 2011-3

Mara Bresjanac

Martina Starc

Rok Berlot

Varnost uporabe generičnih protiepileptičnih zdravil

Mojca Kržan, Matevž Kržan

Možgani, računalniki - nekaj vmes

Miha Pelko

eSinapsa, 2012-4

Ali so moški in ženski možgani različni?

Gregor Majdič

O kognitivnih motnjah pri bolnikih s Parkinsonovo boleznijo

Dejan Georgiev

Akutno možgansko kap lahko uspešno zdravimo

Nina Vujasinovič, Bojana Žvan

Vloga nevropsihološke diagnostike pri odkrivanju zgodnjih znakov alzheimerjeve bolezni

Simon Brezovar

eSinapsa, 2013-5

Učinek placeba brez lažnih zdravil in zavajanja

Mara Bresjanac

Subarahnoidna krvavitev zaradi tromboze venskih sinusov

Mateja Repar, Anita Resman Gašperčič

Srečanje dveh velikanov: možganov in imunskega sistema

Matej Markota

Novo odkritje na področju sporadičnih prionskih bolezni

Jana Jerše, Nadja Jarc

eSinapsa, 2013-6

Odstranjevanje možganskih tumorjev pri budnem bolniku

Andrej Vranič, Jasmina Markovič, Blaž Koritnik

Zmedena bolnica, ki nič ne vidi ali PRES

Manja Hribar, Vid Zgonc

Manja Hribar

Sistemska skleroza in ishemična možganska kap - vzročna povezanost ali le koincidenca?

Mateja Repar, Janja Pretnar Oblak

Netravmatska lokalizirana konveksitetna subarahnoidna krvavitev

Mateja Repar, Fajko F. Bajrović

Klemen Grabljevec

Z omejevanjem spodbujajoča terapija pri bolnikih po nezgodni možganski poškodbi

Dejana Zajc, Klemen Grabljevec

eSinapsa, 2014-7

Možgani v mreži navezanosti, ki nas zaznamuje

Barbara Horvat

Vpliv senzoričnega dotoka na uglasitev možganskih povezav

Peter Gradišnik

Človeški konektom ali kakšne so zveze v naših možganih

Blaž Koritnik

Niko Lah

Torkove delavnice za osnovnošolce

Mateja Drolec Novak, Vid V. Vodušek

Da ne pozabim! Tehnike za pomladitev spomina

Klara Tostovršnik, Hana Hawlina

Površina socialne nevroznanosti

Manuel Kuran

Clarity - bistri možgani Karla Deisserotha

Gregor Belušič

Barbara Gnidovec Stražišar

Bojana Žvan

Nevroplastičnost po možganski kapi

Marjan Zaletel

Klinično psihološka obravnava pacientov po možganski kapi in podpora pri vračanju na delovno mesto

Barbara Starovasnik Žagavec

Možgani: organ, s katerim ljubimo

Andraž Matkovič

Marija Šoštarič Podlesnik

Gibalno-kognitivna vadba: praktična delavnica

Mitja Gerževič, Marina Dobnik

Anton Grad

Nevrologija, imunologija, psihiatrija …

Bojan Rojc

Andraž Stožer, Janez Bregant

Dominika Novak Pihler

Možganska kap – »kako ostati v omrežju?«

Nina Ozimic

Klara Tostovršnik

eSinapsa, 2014-8

Znotrajžilno zdravljenje možganskih anevrizem

Tamara Gorjanc, Dimitrij Lovrič

Obravnava hladnih možganskih anevrizem

Bojana Žvan, Janja Pretnar Oblak

Ali deklice z Rettovim sindromom govorijo z očmi?

Anka Slana, Urška Slana

Progresivna multifokalna encefalopatija

Urša Zabret, Katarina Šurlan Popovič

Ne ubijaj – poskusi na živalih

Martina Perše

Poizkusi na živalih - za in proti

Simon Horvat

eSinapsa, 2015-9

Kako deluje navigacijski sistem v naših možganih

Simon Brezovar

Vsakodnevno delo slepe osebe / s slepo osebo

Denis Kamnar

Uroš Marušič

Manca Tekavčič Pompe

Toni Pustovrh

Marko Hawlina

Od svetlobe do podobe ali kako vidijo svet naši možgani

Simon Brezovar

Janja Hrastovšek

Zala Kurinčič

Pogledi na mejno osebnostno motnjo

Jerica Radež, Peter Kapš

Uvid kot socialno psihološki fenomen

Vid Vodušek

Uvod v vidno-prostorske funkcije s praktičnimi primeri

Ana Bujišić, Sanja Roškar

eSinapsa, 2015-10

Difuzijsko magnetnoresonančno slikanje

Rok Berlot

Katja Pavšič

Radiološko izolirani sindrom - ali ga moramo poznati?

Matej Vouk, Katarina Šurlan Popovič

Kako izgledajo možgani, ki govorijo več jezikov?

Gašper Zupan

Nov pristop v rehabilitaciji - terapija s pomočjo psa

Mateja Drljepan

Pogled v maternico z magnetnoresonančno preiskavo

Taja Jordan, Tina Vipotnik Vesnaver

Saša Zorjan

Saša Zorjan

Nevroestetika: ko nevroznanost obišče galerijo

Anja Voljavec, Hana Hawlina, Nika Vrabič

Ali so psihogeni neepileptični napadi res psihogeni?

Saška Vipotnik, Gal Granda

Kako nam lahko glasna glasba »vzame« sluh in povzroči tinitus

Nejc Steiner, Saba Battelino

eSinapsa, 2016-11

Mara Bresjanac

Kako ultrazvok odpira pot v možgane

Kaja Kolmančič

Kako je epigenetika spremenila nevroznanost

Metka Ravnik Glavač

Ondinino prekletstvo ali sindrom prirojene centralne hipoventilacije

Katja Pavšič, Barbara Gnidovec Stražišar, Janja Pretnar Oblak, Fajko F. Bajrović

Zika virus in magnetnoresonančna diagnostika nepravilnosti osrednjega živčevja pri plodu

Rok Banko, Tina Vipotnik Vesnaver

Motnje ravnotežja otrok in odraslih

Nejc Steiner, Saba Battelino

eSinapsa, 2016-12

Vloga magnetnoresonančne spektroskopije pri obravnavi možganskih tumorjev

Gašper Zupan, Katarina Šurlan Popovič

Tiskanje tridimenzionalnih modelov v medicini

Andrej Vovk

Aleš Oblak

Kevin Klarič

Sinestezija: umetnica, ki ne želi odrasti

Tisa Frelih

Računska psihiatrija: od nevroznanosti do klinike

Nastja Tomat

Kognitivni nadzor: od vsakdanjega življenja do bolezni

Vida Ana Politakis

eSinapsa, 2017-13

Internet: nadgradnja ali nadomestek uma?

Matej Perovnik

Vloga črevesnega mikrobioma pri odzivu na stres

Vesna van Midden

Stres pušča posledice tako na človeškem kot živalskem organizmu

Jasmina Kerčmar

Prikaz normalne anatomije in bolezenskih stanj obraznega živca z magnetno resonanco

Rok Banko, Matej Vrabec

Psihedelična izkušnja in njen zdravilni potencial

Anja Cehnar, Jona Basle

Vpliv hiperglikemije na delovanje možganov

Jasna Šuput Omladič, Simona Klemenčič

Nevrofibromatoza: napredujoče obolenje centralnega in perifernega živčevja

Nejc Steiner, Saba Battelino

Fenomen žrtvenega jagnja v dobi interneta

Dolores Trol

Tesnoba staršev in strategije spoprijemanja, ko pri otroku na novo odkrijejo epilepsijo

Daša Kocjančič, Petra Lešnik Musek, Vesna Krkoč, David Gosar

eSinapsa, 2017-14

Zakaj ne zapeljem s ceste, ko kihnem?

Anka Slana Ozimič, Grega Repovš

Možgani pod stresom: od celic do duševnih motenj

Nastja Tomat

Nobelova nagrada za odkritje molekularnih mehanizmov nadzora cirkadianih ritmov

Leja Dolenc Grošelj

Na sledi prvi vzročni terapiji Huntingtonove bolezni

Danaja Metul

Razlike med spoloma pri Parkinsonovi bolezni

Kaja Kolmančič

eSinapsa, 2018-15

Susceptibilno poudarjeno magnetnoresonančno slikanje pri bolniku z ALS

Alja Vičič, Jernej Avsenik, Rok Berlot

Sara Fabjan

Reverzibilni cerebralni vazokonstrikcijski sindrom – pot do diagnoze

Maja Cimperšek, Katarina Šurlan Popovič

Liam Korošec Hudnik

Kognitivno funkcioniranje pri izgorelosti

Marina Horvat

eSinapsa, 2019-16

Maša Čater

Saša Koprivec

Infekcije osrednjega živčnega sistema s flavivirusi

Maja Potokar

Raziskava: Kako depresija vpliva na kognitivne sposobnosti?

Vida Ana Politakis

Razvoj depresije pri otrocih z vidika navezovalnega vedenja

Neža Grgurevič

Sonja Prpar Mihevc

Umetno inteligentna nevroznanost: srečanje nevronskih mrež in možganske fiziologije

Kristijan Armeni

Čebelji strup pri preventivi nevrodegenerativnih bolezni in priložnost za klinično prakso

Matjaž Deželak

eSinapsa, 2019-17

IgG4+ – skupni imenovalec diagnoz iz preteklosti

Cene Jerele, Katarina Šurlan Popovič

Nov molekulski mehanizem delovanja ketamina v astrocitih

Matjaž Stenovec

Praktični pristop k obravnavi utrujenosti in motenj spanja pri bolnikih z multiplo sklerozo

Nik Krajnc, Leja Dolenc Grošelj

Jure Pešak

eSinapsa, 2020-18

Bolezni spektra anti-MOG pri odraslih

Nik Krajnc

Samomor pod lupo nevroznanosti

Alina Holnthaner

eSinapsa, 2020-19

Ob mednarodnem dnevu znakovnih jezikov

Anka Slana Ozimič

Teorija obetov: kako sprejemamo tvegane odločitve

Nastja Tomat

Sara Fabjan

Matjaž Deželak

Nina Stanojević, Uroš Kovačič

Od človeških nevronov do možganskih organoidov – nova obzorja v nevroznanosti

Vesna M. van Midden

Splošna umetna inteligenca ali statistične jezikovne papige?

Kristijan Armeni

Zunajcelični vezikli kot prenašalci zdravilnih učinkovin preko krvno-možganske prepreke

Saša Koprivec

Matjaž Deželak

eSinapsa, 2021-20

Migrena: starodavna bolezen, sodobni pristopi k zdravljenju

Eva Koban, Lina Savšek

Zgodnji razvoj socialnega vedenja

Vesna Jug

Nastja Tomat

Mikrosplet: povezovanje preko mikrobioma

Tina Tinkara Peternelj

Stimulacija možganov kot način zdravljenja depresije

Saša Kocijančič Azzaoui

eSinapsa, 2021-21

eSinapsa, 2022-22

Sodobni vidiki motenj hranjenja

Karin Sernec

Ples in gibalni dialog z malčki

Neva Kralj

Atul Gawande

Jezikovna funkcija pri Alzheimerjevi bolezni

Gašper Tonin

Dostava terapevtikov preko krvno-možganske pregrade

Matjaž Deželak

eSinapsa, 2022-23

Akutni ishemični infarkt hrbtenjače pri zdravih otrocih – kaj lahko pove radiolog?

Katarina Šurlan Popovič, Barbara Šijaković

eSinapsa, 2023-24

Možganska omrežja pri nevrodegenerativnih boleznih

Tomaž Rus, Matej Perovnik

Morske živali kot navdih za nevroznanstvenike: morski konjiček, morski zajček in klobučnjak

Tina Bregant

Metoda Feldenkrais: gibanje in nevroplastičnost

Mateja Pate

Etično naravnana animalna nevroznanost

Maša Čater

Helena Motaln, Boris Rogelj

eSinapsa, 2023-25

Urban Košak, Damijan Knez, Anže Meden, Simon Žakelj, Jurij Trontelj, Jure Stojan, Maja Zakošek Pipan, Kinga Sałat idr.

eSinapsa, 2024-26

Naravno okolje kot vir zdravja in blagostanja

Karin Križman, Grega Repovš, Gaja Zager Kocjan, Gregor Geršak

Katja Peganc Nunčič, Damjan Osredkar

Tanja Goltnik

Ali je zgodnje vstajanje dedno?

Cene Skubic, Laura Plavc, Damjana Rozman, Leja Dolenc Grošelj

eSinapsa, 2024-27

Širša terapevtska uporaba ketamina: potenciali in izzivi

Kristian Elersič

Moč vpliva socialne opore na bolečino

Jana Verdnik

Benjamin Bušelič

Urška Černe, Anemari Horvat, Robert Zorec, Nina Vardjan

eSinapsa, 2025-28

Maša Čater, Nastja Blagovič, Urška Jerič, Agata Kokalj Malovrh, Nuša Balen, Tanja Kunej

Vpliv izobrazbe na skrb za zdravje možganov

Hana Kos, Matej Perovnik

Selena Horvat, Anja Pišlar

eSinapsa, 2025-29

Knjiga Kje so moji ključi kot primer narativne medicine

Zdenka Čebašek-Travnik, Saša Novak

Kaj je tisto v možganih, kar omogoča, da zvok – potem ko se mehanske in akustične vibracije v ušesu prek bobniča in polževe membrane prevedejo v električne signale – prepoznamo kot besedo? Kognitivna nevroznanost zadnjih nekaj let je postregla z obilico zanimivih empiričnih spoznanj o tem, kako se prostorski in časovni vzorci izmerjene možganske aktivnosti spreminjajo z ozirom na psihološke procese 1. Toda, če velja slediti Feynmanovemu znamenitemu reku »Razumem samo to, kar lahko zgradim«,* potem zgolj na podlagi opažanj takšnih statističnih povezav tudi kognitivni nevroznanstveniki še nismo blizu resničnemu razumevanju možganov … Ali pač?

Poglejmo okoli vogala, k umetni inteligenci (AI). Dandanes lahko marsikatero funkcijo pametnih naprav upravljamo z govornimi ukazi. Prepoznavanje govora (angl. speech recognition) je denimo področje umetne inteligence, kjer smo do danes zgradili tehnologijo, ki na prvi pogled dovolj uspešno konkurira dosežkom človeškega prepoznavanja govora 2. Pa nam tovrstni inženirski preboji lahko pomagajo razumeti delovanje možganov, v katerih korenini človeška inteligenca? Kaj pa če bi se osredotočili na umetne sisteme prepoznavanja govora, ki za povrh v določeni meri utelešajo načela možganskega delovanja? In če bi skušali digitalni vrvež v teh in silico »možganih« primerjati s fiziološkimi meritvami možganskih odzivov, med tem ko udeleženci izvajajo identično nalogo? V prispevku očrtam polje kognitivne računske nevroznanosti, ki je nedavno dobila svojo letno konferenco, in predstavim primer nedavne raziskave na področju razumevanja govora, ki uteleša tovrsten pristop.

Google v možganih, od psihološke do nevrobiološke veljavnosti

Računski modeli – matematični oziroma formalni opisi duševnih procesov, ki domnevno podhodijo človeškemu vedênju, in njihove računalniške implementacije – so tradicionalno eno osrednjih razlagalnih orodij kognitivne znanosti 3. Grajenje računskih sistemov, ki izkažejo sposobnost inteligentnega vedênja, danes poznamo pod imenom AI. V svetu tehnoloških rešitev in aplikacij, ki jih poganja AI, načeloma ni zelo pomembno, ali nek sistem AI reši nalogo na »psihološko« oziroma »biološko veljaven« način; bržkone je pomembneje, da algoritem pri določeni nalogi parira človeški uspešnosti oziroma da je v nekem kontekstu dovolj učinkovit za ciljni namen. Samo pomislimo, kako hitro se ob neposrečenem prevodu strojnega prevajalnika privoščljivo namuznemo in kolikokrat nam ta isti sistem pravzaprav ponudi rešitev, ki resda ni odlična, a vendar dovolj dobra za naš namen.

Ker pa je cilj rabe tovrstnih umetnih sistemov v kognitivni nevroznanosti teoretične in ne zgolj praktične narave, morajo ti zadostiti ne le kriteriju končne učinkovitosti pri nalogi, temveč morajo biti tudi ekološko, psihološko in biološko veljavni 3, 4, 5, 6. Kaj je mišljeno s tem? Na kratko, ekološka veljavnost narekuje, da naj računski model deluje v okolju, ki kar najbolj odslikava lastnosti tipičnega okolja proučevanega organizma. Zgodnji računski modeli branja so denimo procesirali jezike z močno omejenim besediščem, denimo nekaj deset besed 7. To ne odseva velikosti dejanskega besedišča naravnih jezikov – besedišče odraslih govorcev prvih jezikov je ocenjeno med 10.000 in 50.000 besed oziroma enot 8. Pri današnjih standardih bi torej nezmožnost obdelave obširnejšega besedišča veljalo za pomanjkljivost 9. Podobno psihološka veljavnost narekuje, da mora računski model v čim večji meri zaobjeti empirično potrjene psihološke in vedenjske značilnosti organizma pri reševanju določene naloge. Psihološko veljavnost računskih modelov branja se tako pogosto ocenjuje tako, da se preveri, kako dobro ti modeli napovedo čas branja posameznih besed v besedilih, ki ga je pri človeških udeležencih moč meriti s sledilcem očesnih gibov 10.

Kaj pa biološka veljavnost računskih modelov? Če se še nekoliko pomudimo pri prevajalniku: bi kdo statistične algoritme, ki napajajo Googlov strojni prevajalnik, smatral kot uspešno nevrobiološko teorijo prevajanja? Lahko pograbimo posamezne komponente Googlove programske opreme in jih vzporejamo s posameznimi deli možganov? Morda kar z možgansko fiziologijo? Pod kakšnimi pogoji bi si drznili reči, da so tovrstni algoritmi nevrobiološko veljavni oziroma da možganska fiziologija na svojstven način predstavlja njihov približek? Nenazadnje želimo razumeti in razložiti, kakšna »programska oprema« – če obdržimo to metaforo – se najbolje preslika na zgradbo in delovanje možganov oziroma še natančneje: s pomočjo računskih modelov želimo spoznati, katere so ključne lastnosti možganov, ki botrujejo lastnostim inteligentnega vedênja v danem okolju.

Strojno učenje in nevronske mreže

Vstopili smo na polje kognitivne računske nevroznanosti (angl. cognitive computational neuroscience); ta se pri razlagi delovanja možganov opira na grajenje računskih modelov, ki morajo zajemati ključne biofizikalne lastnosti možganov in obenem v določeni meri izkazati zmožnost kognitivnega oziroma inteligentnega vedênja 11. Polje kognitivne računske nevroznanosti je široko; izvajamo lahko računske simulacije na različnih ravneh možganske organizacije: od aktivnosti posamičnih živčnih celic, do manjših nevronskih omrežij (npr. od nekaj 10 do 1000 celic), vse do obsežnih nevronskih mrež s tudi po več milijoni nevronov, kjer so v ospredju globalne vedênjske lastnosti mreže, medtem ko posamezni »nevroni« domala že povsem povozijo biofizikalne lastnosti nevronov 12. In prav v tej zadnji skupini je dandanes posebne pozornosti deležna družina računskih modelov in algoritmov, ki jih je moč graditi s tehnikami statističnega oziroma strojnega učenja – t. i. umetne nevronske mreže (angl. artificial neural networks).

Tehnologija in matematična podlaga nevronskih mrež nista novi, začetki segajo že v 50. leta 20. stoletja, ko je ameriški psiholog Frank Rosenblatt predstavil Perceptron, preprosto usmerjeno nevronsko mrežo, ki je lahko prepoznavala pisane črke 13. Z izrazom statistično učenje (angl. statistical learning) oziroma strojno učenje (angl. machine learning) označujemo nabor algoritmov, s katerimi vedênje nevronske mreže (njene parametre) v fazi učenja nastavimo (optimiziramo) tako, da bo ta kar najbolj uspešna pri reševanju določene naloge (npr. prepoznavanja oziroma klasifikacije besed v zvočnem posnetku govora). V nevronskih mrežah so parametri (tudi: uteži), ki jih »uglašujemo«, interpretirani kot povezave (analogne sinapsam) med posameznimi računskimi enotami (analogne nevronom). Naučeno mrežo, tj. ko so sinaptične povezave uglašene na vrednosti, pri katerih je vedenjska uspešnost nevronske mreže najvišja, lahko nato izpostavimo novim dražljajem, ki niso bili uporabljeni v fazi učenja. Tako torej dobimo in silico udeleženca v eksperimentu.

Glavna razloga, da so nevronske mreže in strojno učenje v zadnjih letih ponovno pridobile na veljavi, sta (tako v industrijskih aplikacijah kot v raziskavah) predvsem porast in dostopnost računske moči in posledično zmožnost strojnega učenja večnivojskih mrež (angl. multilayer networks) z veliki številom nevronov in parametrov – sinaps (t. i. globoko učenje, angl. deep learning) 13. Tretji razlog pa je presenetljivo sovpadanje med dinamiko procesov v takšnih »globokih mrežah« in možganskimi fiziološkimi odzivi, kadar nevronske mreže in človeški udeleženci rešujejo identično nalogo. Poglejmo si primer nedavne raziskave, ki ilustrira omenjen pristop.

Najprej je bila beseda

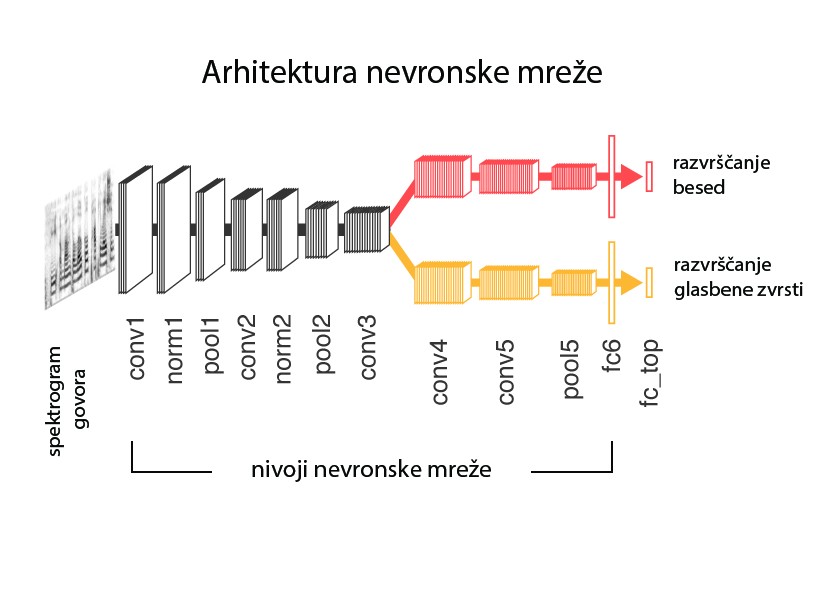

Kakšne operacije in v katerem delu možganov potekajo, kadar v zvočnem signalu prepoznamo izgovorjeno besedo? Kell in sodelavci 14 so umetno nevronsko mrežo naučili prepoznavanja besed in prepoznavanja glasbenih zvrsti v približno 2 sekundi dolgih posnetkih govora in skladb (slika 1). Nevronsko mrežo so torej optimizirali za izvajanje dveh nalog, ki ju večina izmed nas uspešno »rešuje« na dnevni ravni. V vsakdanjem življenju smo resda soočeni z daljšimi in kompleksnejšimi dražljaji (ekološka veljavnost!), toda prepoznavanje posamičnih besed je vendarle kognitivno zanimiva naloga; če na primer želimo razumeti neko kompleksno besedilo, moramo bržčas prepoznati tudi posamezne besede.

Slika 1: Končna arhitektura nevronske mreže, uporabljene v študiji Kella in sodelavcev 14. Mreža kot vhodne podatke zajame spektrogram posnetka govora (oziroma pesmi) in ga skozi več nivojev transformacij razvrsti (klasificira) na besede, ki so vključene v besedišče. Oznake nivojev predstavljajo matematično transformacijo, ki se izvaja s posameznim nivojem (»Conv« – konvolucijski nivo, »pool« – združevalni nivo, »norm« – normalizacijski nivo, »fcb« – polnopovezan nivo). Najvišje razvrščena beseda je smatrana kot prepoznana beseda. Moči povezav oziroma uteži (sinaps) med posameznimi računskimi enotami (nevroni) v nivojih so določene na podlagi uspešnosti mreže v fazi učenja. Nevronska mreža je torej optimizirana za prepoznavanje besed (in glasbenih zvrsti). Povzeto in prevedeno po Kell in sodelavci14, slika 1 (avtorjeva različica, prevod: K.A.).

Slika 1: Končna arhitektura nevronske mreže, uporabljene v študiji Kella in sodelavcev 14. Mreža kot vhodne podatke zajame spektrogram posnetka govora (oziroma pesmi) in ga skozi več nivojev transformacij razvrsti (klasificira) na besede, ki so vključene v besedišče. Oznake nivojev predstavljajo matematično transformacijo, ki se izvaja s posameznim nivojem (»Conv« – konvolucijski nivo, »pool« – združevalni nivo, »norm« – normalizacijski nivo, »fcb« – polnopovezan nivo). Najvišje razvrščena beseda je smatrana kot prepoznana beseda. Moči povezav oziroma uteži (sinaps) med posameznimi računskimi enotami (nevroni) v nivojih so določene na podlagi uspešnosti mreže v fazi učenja. Nevronska mreža je torej optimizirana za prepoznavanje besed (in glasbenih zvrsti). Povzeto in prevedeno po Kell in sodelavci14, slika 1 (avtorjeva različica, prevod: K.A.).

Motiti se je človeško

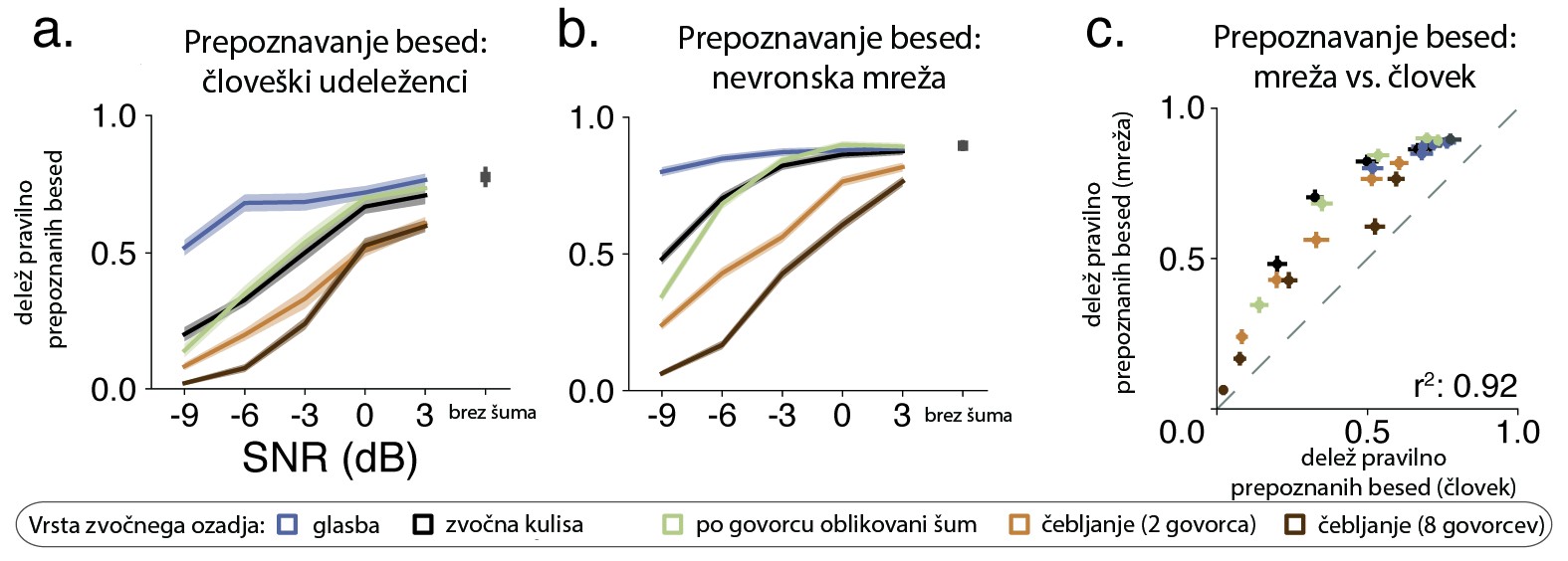

Glavni kriterij psihološke veljavnosti računskega modela je, kako dobro lahko izkaže vedênje, podobno človeškemu. Kell in sodelavci so primerjali uspešnost naučene nevronske mreže in ljudi, udeleženih v raziskavi, pri prepoznavi oziroma razvrščanju posnetkov na besede in glasbene zvrsti. Izkazalo se je, da je vedênje nevronske mreže, tj. njeni odstotki pravilno prepoznanih besed, primerljivo z vedênjem udeležencev (slika 2). Zanimivo, kadar je bil posnetkom dodan hrup oziroma šum, je nevronska mreža pravilno razvrstila govorjeno besedo v manj kot petdeset odstotkih vseh poskusov, podobno kot človeški udeleženci. Ko je bilo šuma bistveno manj, je uspešnost poskočila na 70–80 %, zopet podobno kot pri ljudeh. Če smo natančni, je bila uspešnost nevronske mreže pravzaprav celo nekoliko višja od človeške. V svetu strojnega učenja in umetne inteligence to ni nov pojav; nevronske mreže, optimizirane za prepoznavanje slik (angl. image recognition), so dandanes neredko uspešnejše od človeških udeležencev 15.

Slika 2: Vedenjska uspešnost prepoznavanja besed in glasbenih zvrsti pri človeških udeležencih (A) in nevronski mreži (B) ter statistična povezanost med vedenjsko uspešnostjo mreže in človeških udeležencev (C). SNR –razmerje signal/šum. Povzeto po Kell in sodelavci 14 (avtorjeva različica, prevod: K.A.).

Slika 2: Vedenjska uspešnost prepoznavanja besed in glasbenih zvrsti pri človeških udeležencih (A) in nevronski mreži (B) ter statistična povezanost med vedenjsko uspešnostjo mreže in človeških udeležencev (C). SNR –razmerje signal/šum. Povzeto po Kell in sodelavci 14 (avtorjeva različica, prevod: K.A.).V tej fazi je možno zaključiti, da je vedênje nevronske mreže do neke mere psihološko veljavno. Ne le da je uspešnost umetnega sistema podobna človeški, tudi kadar so okoliščine težavne (šum), se zmoti v podobnem obsegu kot človek. Kaj pa nevrobiološka veljavnost? Je notranja arhitektura nevronske mreže primerljiva dinamiki bioloških možganskih odzivov, merjenih s funkcionalno magnetno resonanco (fMRI)? Ali obstaja statistična povezanost med meritvami možganske aktivnosti in zgradbo oziroma računskimi procesi v umetni nevronski mreži?

Nivoji nevronskih mrež

V splošnem si nevronsko mrežo lahko zamislimo kot sistem, sestavljen iz niza matematičnih operacij. Tako imenovani nevroni so razporejeni v sloje oziroma nivoje (angl. layers), ki vhodne podatke (npr. zvočni posnetek govora) pretvorijo v želeni vedenjski odziv, npr. prepoznavanje oziroma razvrščanje besed (slika 1). Med vhodnim in izhodnim nivojem je navadno več vmesnih, t. i. skritih nivojev (angl. hidden layers) nevronov, navadno nekaj deset. Vsak posamezen nevron (v enem nivoju jih je lahko po več sto) si nadalje lahko zamislimo kot matematično funkcijo, ki kot podatke prek vhodnih povezav (uteži) prejme informacije o aktivacijah vseh nevronov nižjega nivoja in kot rezultat navede lastno aktivacijo oziroma stanje. Kako močno aktivnost posameznih nevronov v predhodnem nivoju vpliva na aktivnost določenega nevrona naslednjega nivoja je odvisno od vzorca in moči sinaptičnih povezav, in prav to so vrednosti, ki jih »uglasimo« v fazi učenja naloge. Računske operacije znotraj mreže, ki botrujejo njeni »inteligenci«, so tako posledica prilagoditve na reševanje naloge.

Z vidika kognitivne nevroznanosti je zanimivo, da v nalogah prepoznavanja slik naučene nevronske mreže po fazi učenja v omenjenih nivojih razvijejo občutljivost na določene dražljaje oziroma določene lastnosti slik, torej razvijejo svojstveno receptivno polje (angl. receptive field). Skriti nivoji takšnih nevronskih mrež postanejo denimo postopno občutljivi za zaznavanje kontrasta, robov, oblike podob itn., kar je sicer tudi eno osnovnih spoznanj v fiziologiji vidnega zaznavanja 16. Gre za eno bolj zanimivih sovpadanj med umetnimi in biološkimi sistemi, ki je bilo do danes večkrat empirično potrjeno 17, 18, 19.

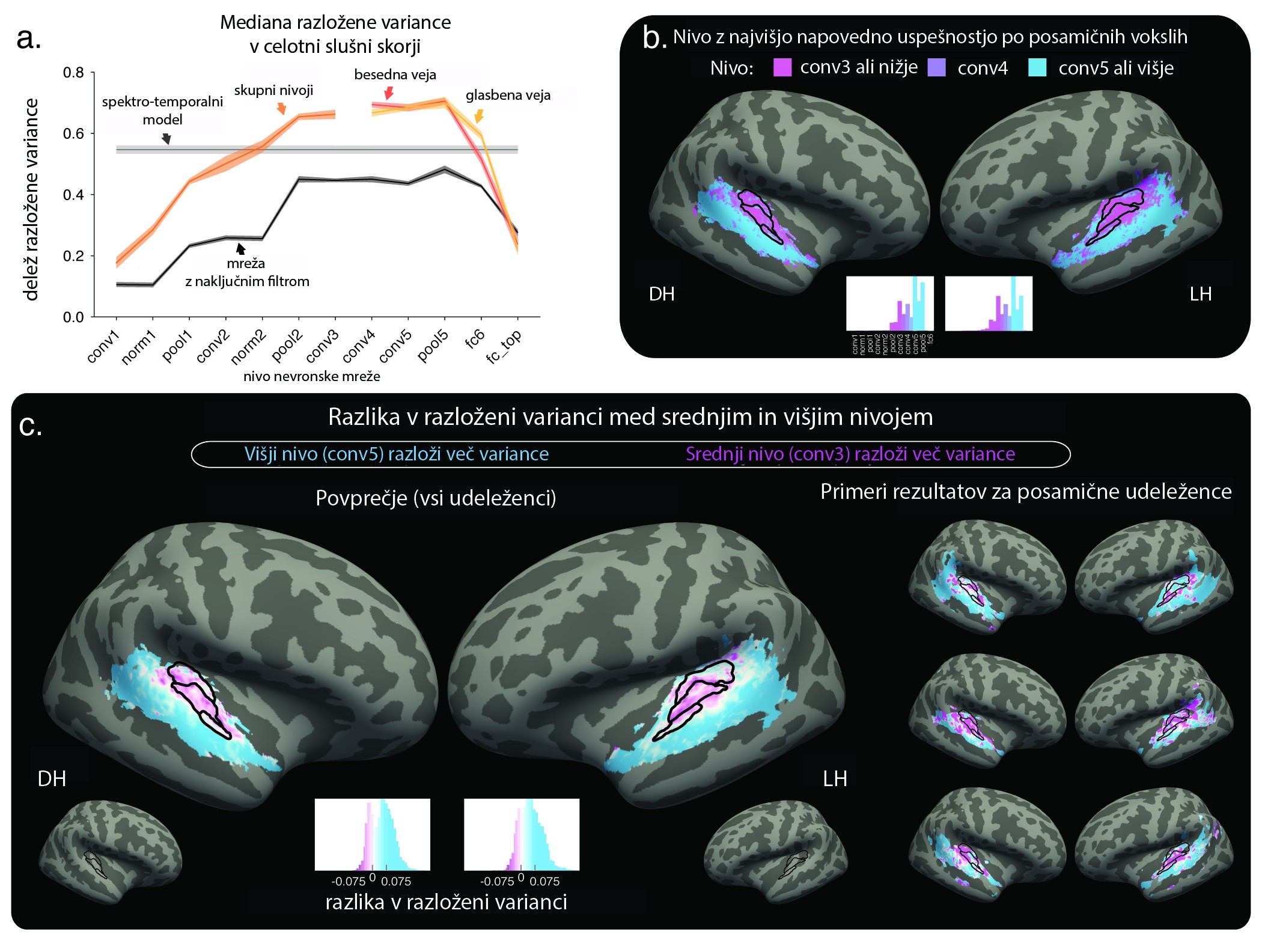

Aleksander Kell in ekipa so najprej primerjali, kako dobro različni modeli slušnega zaznavanja napovedo vrednosti izmerjenega hemodinamičnega signala v slušni skorji (slika 3). Natančneje: kolikšen delež variance v merjenem možganskem signalu je moč pojasniti na podlagi aktivnosti nevronov v posamičnih nivojih mreže. Primerjava pokaže, da je učena nevronska mreža statistično uspešnejša tako od standardnega modela (uveljavljen model kohlearnega procesiranja v slušni nevroznanosti) kot tudi od nevronske mreže, kjer so sinaptične povezave ustvarjene naključno, torej brez učenja (slika 3, a).

Slika 3: Slika 3 A) Delež razložene variance fMRI-signala na podlagi aktivnosti nevronov v različnih nivojih nevronske mreže. B) Prostorska porazdeljenost uspešnosti posamičnih nivojev nevronske mreže. Deli slušne skorje so razvrščeni v dve skupini glede na to, ali so v posamičnem vokslu boljši napovedni dejavnik možganske aktivnosti srednji (vijolično) ali višji nivoji (modro). C) Podobno kot B, le da barve ne ponazarjajo nivojev, ampak dejansko razliko v razloženi varianci med višjim in srednjim nivojem. Pozitivna razlika (modro) pomeni, da več variance razloži višji nivoji in obratno. Povzeto po Kell in sodelavci 14, slika 5 (avtorjeva različica, prevod: K.A.). DH – desna hemisfera. LH – leva hemisfera.

Slika 3: Slika 3 A) Delež razložene variance fMRI-signala na podlagi aktivnosti nevronov v različnih nivojih nevronske mreže. B) Prostorska porazdeljenost uspešnosti posamičnih nivojev nevronske mreže. Deli slušne skorje so razvrščeni v dve skupini glede na to, ali so v posamičnem vokslu boljši napovedni dejavnik možganske aktivnosti srednji (vijolično) ali višji nivoji (modro). C) Podobno kot B, le da barve ne ponazarjajo nivojev, ampak dejansko razliko v razloženi varianci med višjim in srednjim nivojem. Pozitivna razlika (modro) pomeni, da več variance razloži višji nivoji in obratno. Povzeto po Kell in sodelavci 14, slika 5 (avtorjeva različica, prevod: K.A.). DH – desna hemisfera. LH – leva hemisfera.Z grafa A na sliki 3 je razvidno tudi, da napovedna uspešnost ni enakomerno razporejena med nivoji nevronske mreže; nevroni določenih nivojev so uspešnejši kot nevroni drugih nivojev. Predvsem skriti nivoji, ki se nahajajo med vhodnimi in izhodnimi, so uspešnejši pri napovedovanju možganskega signala. Z drugimi besedami, dinamika računskih operacij v srednjih nivojih, ki predstavljajo faze med vhodnim zajemom spektrograma govora oziroma pesmi in izhodnim razvrščanjem besed, močneje statistično sovpada z izmerjenim možganskim signalom v slušni skorji.

Ko ocenjujemo napovedno uspešnost po posamičnih nivojih, je govora o mediani uspešnosti v celotni slušni skorji. Kaj pa če se vprašamo o prostorski specifičnosti te statistične povezanosti – kje v slušni skorji so določeni nivoji uspešnejši? Če dele slušne skorje razvrstimo glede na to, kateri nivoji so najuspešnejši, je moč opaziti delitev na dve področji: posteriorno-superiorni del slušne skorje v senčnem režnju, kjer so uspešnejši napovedni dejavnik srednji in nižji nivoji nevronov (slika 3, b in c, vijolično), ter anteriorno-inferiorni del (slika 3, b in c, modro), kjer so uspešnejši globlji oz. višji nivoji. Nevronska mreža z naključno določenimi sinaptičnimi povezavami ne izkaže podobnega gradienta v napovedni uspešnosti.

Rezultati torej kažejo na svojevrstno hierarhično organizacijo, kjer možganska aktivnost v delih slušne skorje, ki so bližje vhodnemu senzoričnemu signalu, močneje sovpada z aktivnostjo skritih nivojev nevronske mreže, ki so bližje vhodnim nivojem, in obratno. V prispevku smo predstavili le glavne rezultate raziskave Alexandra Kella in sodelavcev. Študija je obsežna in vključuje številne dodatne analize, ki jih v tem prispevku zavoljo zadoščenja prostorskim omejitvam ne navajamo. Za zaključek si poglejmo, kam nas kognitivna računska nevroznanost pelje od tu naprej.

Razumeti možgane

Ogledali smo si primer raziskave kognitivne računske nevroznanosti. Ekipa Alexandra Kella je pokazala, da so vedenjski rezultati nevronske mreže pri prepoznavanju besed in glasbenih zvrsti podobni vedenjskim vzorcem človeških udeležencev. S primerjavo umetnega kognitivnega sistema in možganske fiziologije (signal fMRI) so raziskovalci očrtali možne vzporednice med procesi, ki potekajo v obeh sistemih. A tu se pravo delo šele začne: ne glede na impresivno kvoto tehnične sofistikacije je študija Kella in sodelavcev namreč korelacijska. Nazorno pokaže na zanimiv fenomen – statistično povezanost med procesi v umetnem in biološkem sistemu – a ga na tej točki vendarle še ne razloži. Kaj botruje izpričani povezanosti? Zakaj je napovedna uspešnost najvišja za nevrone v srednjih nivojih? Kot izpostavijo tudi avtorji študije, je tukajšnji vzorec rezultatov nekoliko drugačen od vzorcev pri nalogah prepoznavanja slik, kjer so z najbolj perifernimi deli vidne skorje najbolj povezani najnižji – in ne srednji – nivoji nevronskih mrež.

Da bi prišli do odgovora, moramo pomisliti tudi na nadaljnje vidike biološke veljavnosti umetnih nevronskih mrež. Nevroni v umetnih mrežah denimo ne prožijo akcijskih potencialov, ampak imajo aktivacijski profil, ki je izbran tako, da ustreza matematičnim zahtevam izbranih algoritmov strojnega učenja, sicer učenje ni možno. »Fiziologija« umetnih nevronov je torej pragmatično izbrana za potrebe strojnega učenja 20, 21, 22. Če želimo razumeti, kako poteka procesiranje in učenje z biološkimi nevroni, potem moramo v računske modele vključiti dinamiko, ki sledi elektrofiziološkim lastnostim nevronov 23. Razumevanje računskih operacij, ki potekajo znotraj mreže, z ozirom na kognitivne teorije, je namreč ključnega pomena, če želimo razložiti, zakaj prihaja do izpričane povezanosti med fiziologijo in umetnimi sistemi 24.

Poleg nadaljnjega potrjevanja biološke in psihološke veljavnosti umetnih nevronskih mrež se lahko torej v prihodnje nadejamo še močnejšega zasuka k iskanju biološko veljavnih arhitektur in algoritmov; na primer razvoj globokega učenja z nevronskimi mrežami, kjer nevroni vključujejo dinamiko akcijskih potencialov 25, učenje z algoritmi, ki izkoristijo načela možganske anatomije in strukture nevronskih celic 26, 27 oziroma razvoj algoritmov, ki lahko aproksimirajo in parirajo trenutno najuspešnejšim, a pretežno biološko neveljavnim algoritmom učenja v umetnih nevronskih mrežah 22, 27, 28. V nasprotnem primeru lahko vnovičen preboj AI v kognitivni nevroznanosti smatramo kot še enega v nizu inženirskih »čudodelstev«, ki pa ne ponudi konkretnejših uvidov v načela delovanja možganov. Vprašanja, ki bodo bržčas tvorila jedro programa nove znanstvene konference s transparentnim imenom Kognitivna računska nevroznanost 29. Ta se bo v svoji tretji izdaji, in prvič na tleh stare celine, predstavila jeseni 2019 v Berlinu.

Opombe

*Izvirnik napisa v angleščini (»What I cannot create, I do not understand«) so našli na tabli v delovnem kabinetu znanega fizika Richarda Feynmana po njegovi smrti. Fotografija iz arhiva inštituta Caltech: http://archives.caltech.edu/pictures/1.10-29.jpg.

Zahvala

Avtor prispevka se zahvaljuje Alexandru Kellu za dostop do slikovnega gradiva in Žigi Pušniku za terminološki pregled.

-

___

-

Raichle ME. A brief history of human brain mapping. Trends in Neurosciences. 2009;32(2):118-126. doi:10.1016/j.tins.2008.11.001 ↩

-

Pieraccini R. The Voice in the Machine. MIT Press; 2012. https://mitpress.mit.edu/books/voice-machine. Accessed December 17, 2018. ↩

-

Varela FJ, Thompson E, Rosch E. The Embodied Mind: Cognitive Science and Human Experience. revised edition. Cambridge, Massachusetts ; London England: MIT Press; 2016. ↩

-

Gibson JJ. The Ecological Approach to Visual Perception. New York, London: Psychology Press; 2015. ↩

-

Keller F. Cognitively plausible models of human language processing. In: ACL 2010, Proceedings of the 48th Annual Meeting of the Association for Computational Linguistics. Uppsala, Sweden: Association for Computational Linguistics; 2010:60–67. http://www.aclweb.org/anthology/P10-2012. ↩

-

O’Reilly RC. Biologically based computational models of high-level cognition. Science. 2006;314(5796):91-94. doi:10.1126/science.1127242 ↩

-

Elman J. Finding structure in time. Cognitive Science. 1990;14(2):179-211. doi:10.1016/0364-0213(90)90002-E ↩

-

Brysbaert M, Stevens M, Mandera P, Keuleers E. How many words do we know? Practical wstimates of vocabulary size dependent on word definition, the degree of language input and the participant’s age. Frontiers in Psychology. 2016;7. doi:10.3389/fpsyg.2016.01116 ↩

-

Frank SL. Getting real about systematicity. In: The Architecture of Cognition: Rethinking Fodor and Pylyshyn’s Systematicity Challenge. MIT Press; 2014:147-164. https://repository.ubn.ru.nl/handle/2066/131345. Accessed August 27, 2018. ↩

-

Demberg V, Keller F. Data from eye-tracking corpora as evidence for theories of syntactic processing complexity. Cognition. 2008;109(2):193-210. doi:10.1016/j.cognition.2008.07.008 ↩

-

Kriegeskorte N, Douglas PK. Cognitive computational neuroscience. Nature Neuroscience. 2018;21(9):1148-1160. doi:10.1038/s41593-018-0210-5 ↩

-

Herz AVM, Gollisch T, Machens CK, Jaeger D. Modeling single-neuron dynamics and computations: A balance of detail and abstraction. Science. 2006;314(5796):80-85. doi:10.1126/science.1127240 ↩

-

Sejnowski TJ. The Deep Learning Revolution. Cambridge, Massachusetts: The MIT Press; 2018. ↩

-

Kell AJE, Yamins DLK, Shook EN, Norman-Haignere SV, McDermott JH. A task-optimized neural network replicates human auditory behavior, predicts brain responses, and reveals a cortical processing hierarchy. Neuron. 2018;98(3):630-644.e16. doi:10.1016/j.neuron.2018.03.044 ↩

-

Russakovsky O, Deng J, Su H, et al. ImageNet Large Scale Visual Recognition Challenge. International Journal of Computer Vision. 2015;115(3):211-252. doi:10.1007/s11263-015-0816-y ↩

-

Hubert DH, Wiesel TN. Receptive fields, binocular interaction and functional architecture in the cat’s visual cortex. Journal of Physiology. 1962;160:106-154. ↩

-

Khaligh-Razavi S-M, Kriegeskorte N. Deep supervised, but not unsupervised, models may explain IT cortical representation. Diedrichsen J, ed. PLoS Computational Biology. 2014;10(11):e1003915. doi:10.1371/journal.pcbi.1003915 ↩

-

Güçlü U, Gerven MAJ van. Deep neural networks reveal a gradient in the complexity of neural representations across the ventral stream. J Neurosci. 2015;35(27):10005-10014. doi:10.1523/JNEUROSCI.5023-14.2015 ↩

-

Eickenberg M, Gramfort A, Varoquaux G, Thirion B. Seeing it all: Convolutional network layers map the function of the human visual system. NeuroImage. 2017;152:184-194. doi:10.1016/j.neuroimage.2016.10.001 ↩

-

Maass W. Networks of spiking neurons: The third generation of neural network models. Neural Networks. 1997;10(9):1659-1671. doi:10.1016/S0893-6080(97)00011-7 ↩

-

Rumelhart DE, Hinton GE, Williams RJ. Learning representations by back-propagating errors. Nature. 1986;323(6088):533-536. doi:10.1038/323533a0 ↩

-

Whittington JCR, Bogacz R. Theories of error back-propagation in the brain. Trends in Cognitive Sciences. 2019;23(3):235-250. doi:10.1016/j.tics.2018.12.005 ↩

-

Marblestone AH, Wayne G, Kording KP. Toward an integration of deep learning and neuroscience. Front Comput Neurosci. 2016;10. doi:10.3389/fncom.2016.00094 ↩

-

Cichy RM, Kaiser D. Deep neural networks as scientific models. Trends in Cognitive Sciences. 2019;23(4):305-317. doi:10.1016/j.tics.2019.01.009 ↩

-

Tavanaei A, Ghodrati M, Kheradpisheh SR, Masquelier T, Maida AS. Deep learning in spiking neural networks. arXiv:180408150 [cs]. April 2018. http://arxiv.org/abs/1804.08150. Accessed September 24, 2018. ↩

-

Guerguiev J, Lillicrap TP, Richards BA. Towards deep learning with segregated dendrites. eLife. 2017;6. doi:10.7554/eLife.22901 ↩

-

Sacramento J, Ponte Costa R, Bengio Y, Senn W. Dendritic cortical microcircuits approximate the backpropagation algorithm. In: Bengio S, Wallach H, Larochelle H, Grauman K, Cesa-Bianchi N, Garnett R, eds. Advances in Neural Information Processing Systems 31. Curran Associates, Inc.; 2018:8735–8746. http://papers.nips.cc/paper/8089-dendritic-cortical-microcircuits-approximate-the-backpropagation-algorithm.pdf. ↩

-

Costa RP, Assael YM, Shillingford B, de Freitas N, Vogels TP. Cortical microcircuits as gated-recurrent neural networks. arXiv:171102448 [cs, q-bio, stat]. November 2017. http://arxiv.org/abs/1711.02448. Accessed November 20, 2017. ↩

-

Naselaris T, Bassett DS, Fletcher AK, et al. Cognitive computational neuroscience: A new conference for an emerging discipline. Trends in Cognitive Sciences. February 2018. doi:10.1016/j.tics.2018.02.008 ↩

Kristijan Armeni

Donders Institute for Brain, Cognition and Behaviour,

Radboud University, Nizozemska

Prejeto: 7.1.2019

Objavljeno: 30.4.2019